文章生成

技术思想及原理分析

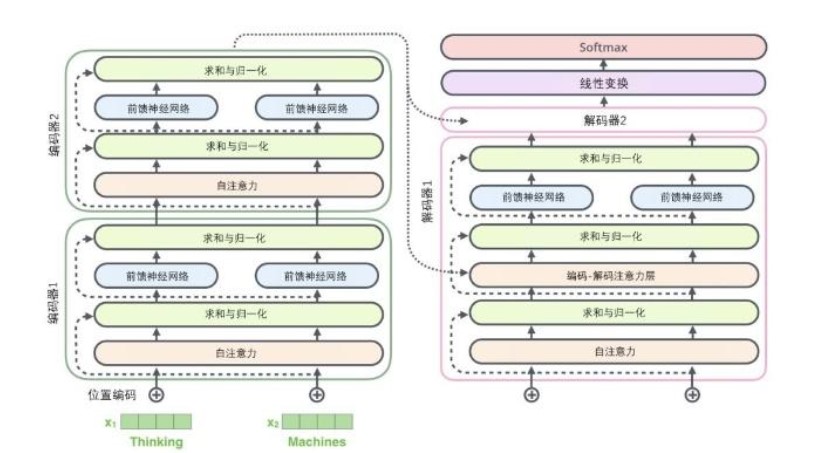

文本生成是一种创造性的工作,比如让神经网络写一篇文章,写一首诗词等,都算是文本生成类的任务。文本生成模型通过学习大量的某类型的语料数据就可以生成这一类别的文章,目前流行的文本生成类模型还是以transformer、Bert、GPT以及他们的一些变种模型为主。其难度是由于模型通过不断的堆叠编码器和解码器导致其参数越来越多,对算力要求也越来越大,不利于小型设备训练和使用。下图是transformer模型的结构图,一个较小的模型就有6个编码器和6个解码器堆叠而成,而每个编码器和解码器并不是卷积模型,全都是全连接模型,这导致了参数量进一步的增大。

应用场景及商业价值

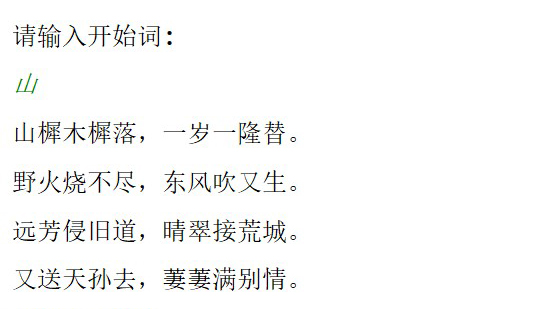

文本生成主要可以用来写文章,自动生成新闻,自媒体软文等,其应用范围非常广泛,但是想要达到好的效果,还是要更大的模型才能完成的。如果受限于设备的算力,无法使用较大的模型来训练,可以考虑云算力来提高训练效率。左图是训练了十几首唐诗,来自动生成诗词的GPT2的模型,可以看到,由于数据量较小,模型学习到的字数也不多,只能从很小的可学习的字库中拼凑,诗词效果也就一般。